por William Michael Carter

Mi madre siempre decía que tenía una cara para la radio. Gracias a Dios, ya que la radio puede ser el último lugar en este mundo realzado por la tecnología donde tu rostro no determinará tu estatus social o tu potencial para cometer un crimen.

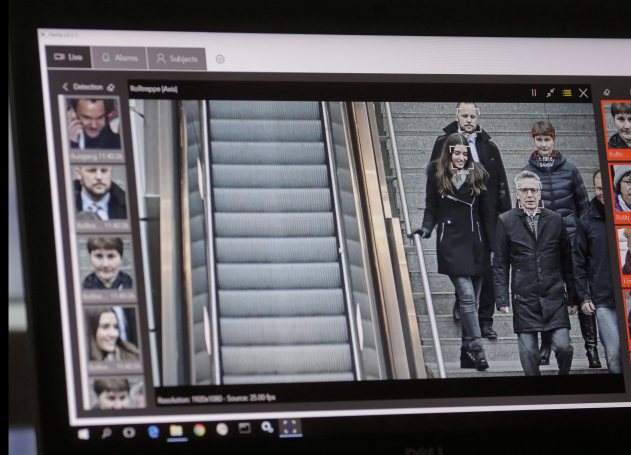

RealNetworks, el líder mundial de una tecnología que permite la entrega digital de archivos de audio y vídeo a través de Internet, acaba de lanzar su última visión por ordenador: Un paquete de software de aprendizaje de máquina. La esperanza es que este nuevo software detecte y pueda predecir comportamientos sospechosos a través del reconocimiento facial.

Llamado SAFR (Secure, Accurate Facial Recognition), , el conjunto de herramientas se ha comercializado como una forma rentable de integrarse sin problemas en los sistemas de vigilancia por vídeo CCTV existentes. Será capaz de “detectar y emparejar millones de rostros en tiempo real”, específicamente en los entornos escolares.

Ostensiblemente, RealNetworks ve su tecnología como algo que puede hacer el mundo más seguro. Sin embargo, la marca pegadiza enmascara los verdaderos problemas éticos que rodean el despliegue de los sistemas de detección facial. Algunas de esas cuestiones incluyen preguntas sobre los sesgos inherentes al código y, en última instancia, cómo se utilizan los datos capturados.

El modelo chino

El Gran Hermano está mirando. Ningún otro país del mundo tiene más vigilancia por video que China. Con 170 millones de cámaras de vídeovigilancia y unos 400 millones de cámaras nuevas instaladas, es un país que ha adoptado e implantado el reconocimiento facial de forma orwelliana.

En un futuro próximo, sus ciudadanos, y aquellos de nosotros que viajamos allí, estaremos expuestos a una vasta e integrada red de sistemas de reconocimiento facial que monitorean todo, desde el uso del transporte público hasta el exceso de velocidad y la cantidad de papel higiénico que uno usa en el baño público.

El elemento más perturbador hasta ahora es la reciente introducción del reconocimiento facial para controlar el comportamiento de los niños en las escuelas públicas chinas.

Como parte de la plena integración de China de su sistema de crédito social igualmente orwelliano -un programa de incentivos que premia el compromiso de cada ciudadano con la moral dictada por el Estado-, este sistema digital totalmente integrado identificará automáticamente a una persona. Puede entonces determinar la capacidad de uno para progresar en la sociedad -y, por extensión, la situación económica y social de la familia inmediata de la persona- mediante el monitoreo del comportamiento no sancionado por el Estado.

En esencia, el reconocimiento facial hace imposible que las personas expuestas puedan darse el lujo de tener un mal día.

Los sistemas de reconocimiento facial que ahora se están implementando en las escuelas chinas están monitoreando todo, desde la asistencia a clase hasta si un niño está soñando despierto o prestando atención. Se trata de un sistema de monitorización integral que determina, en gran medida, el futuro de un niño sin tener en cuenta que algunas cualidades, como el pensamiento abstracto, no pueden detectarse fácilmente o, en el mejor de los casos, considerarse favorablemente, con el reconocimiento facial.

También plantea algunas nociones muy incómodas de la ética o la falta de ética, especialmente hacia los miembros más vulnerables de la sociedad.

Necesidad de una regulación pública

El lanzamiento de RealNetworks de SAFR sigue al apasionado manifiesto del presidente de Microsoft, Brad Smith, sobre la necesidad de regulación pública y responsabilidad corporativa en el desarrollo e implementación de la tecnología de reconocimiento facial.

Smith señaló con razón que las herramientas de reconocimiento facial todavía están algo sesgadas y tienen “mayores tasas de error para las mujeres y las personas de color”. Este problema es doble, con el reconocimiento de que las personas que codifican pueden inconscientemente incrustar sesgos culturales.

Es posible que los conjuntos de datos actualmente disponibles carezcan de la solidez objetiva necesaria para garantizar que los rostros de las personas no se identifiquen erróneamente o, lo que es peor, se predeterminen a través de un sesgo codificado, como está empezando a ocurrir en el sistema escolar chino.

En un esfuerzo por abordar este y muchos otros problemas relacionados, Microsoft estableció un Comité de IA y Ética en Ingeniería e Investigación (AETHER). Este comité también se ha creado para ayudarles a cumplir con el recién aplicado Reglamento General de Protección de Datos (GDPR) de la Unión Europea y su futura adopción, de alguna forma, en América del Norte.

El ardiente atractivo de Smith cuestiona, con razón, el uso y la implementación actual y futura de los sistemas de reconocimiento facial, pero no aborda la forma en que Microsoft o, por extensión, otros líderes de la tecnología de inteligencia artificial pueden eliminar los sesgos dentro de su código base o conjuntos de datos desde el principio.

Minority report

Los rasgos de nuestro rostro no son más que gestos que la fuerza de la costumbre ha hecho permanentes. – Marcel Proust, 1919

Como muchas tecnologías, Pandora ya ha salido de la caja. Si tienes un teléfono inteligente y utilizas Internet, ya has optado por dejar de lado cualquier noción básica de anonimato personal dentro de la sociedad occidental.

Con GDPR ahora plenamente comprometido en Europa, visitar un sitio web ahora requiere que usted “opte” por la posibilidad de que ese sitio web pueda estar recopilando datos personales. Los sistemas de reconocimiento facial no tienen medios para seguir las reglas de GDPR, por lo que nosotros, como sociedad, estamos automáticamente “optados (opt in)” y, por lo tanto, completamente a merced de cómo nuestras caras están siendo grabadas, procesadas y almacenadas por sistemas de vídeovigilancia gubernamentales, corporativos o incluso de despliegue privado.

Los ensayos de reconocimiento facial realizados en Inglaterra por la Policía Metropolitana de Londres han arrojado sistemáticamente una tasa de fracaso del 98%. Del mismo modo, en el suroeste de Gales, los resultados de las pruebas han sido sólo ligeramente mejores, con menos de un 10% de éxito.

Por el contrario, los científicos de la Universidad de California, Berkeley, han llegado a la conclusión de que la variación facial sustancial es un rasgo evolutivo exclusivo de los seres humanos. ¿Dónde está la desconexión?

Si como Marcel Proust ha sugerido, nuestras vidas y por lo tanto nuestras personalidades son identificables por nuestras caras, ¿por qué los sistemas de reconocimiento facial no pueden fácilmente devolver resultados positivos?

La respuesta se remonta a cómo se escribe la programación de la computadora y los conjuntos de datos utilizados por ese código para devolver una coincidencia positiva. Inevitablemente, el código se escribe para apoyar una noción idealizada de tipo facial.

Como tal, las variaciones periféricas como las deformidades faciales naturales o los rasgos faciales afectados por traumas físicos o mentales representan sólo una pequeña fracción de las infinitas variaciones faciales posibles en el mundo. Los conjuntos de datos asumen que somos doppelgängers homogéneos entre sí, sin abordar las micro-variaciones de las caras de los pueblos.

Si ese es el caso, todos estamos sujetos a la posibilidad de que nuestros rostros, interpretados por el creciente despliegue de sistemas de reconocimiento facial inmaduros, traicionen la realidad de quienes somos.

por William Michael Carter

Mi madre siempre decía que tenía una cara para la radio. Gracias a Dios, ya que la radio puede ser el último lugar en este mundo realzado por la tecnología donde tu rostro no determinará tu estatus social o tu potencial para cometer un crimen.

RealNetworks, el líder mundial de una tecnología que permite la entrega digital de archivos de audio y vídeo a través de Internet, acaba de lanzar su última visión por ordenador: Un paquete de software de aprendizaje de máquina. La esperanza es que este nuevo software detecte y pueda predecir comportamientos sospechosos a través del reconocimiento facial.

Llamado SAFR (Secure, Accurate Facial Recognition), , el conjunto de herramientas se ha comercializado como una forma rentable de integrarse sin problemas en los sistemas de vigilancia por vídeo CCTV existentes. Será capaz de “detectar y emparejar millones de rostros en tiempo real”, específicamente en los entornos escolares.

Ostensiblemente, RealNetworks ve su tecnología como algo que puede hacer el mundo más seguro. Sin embargo, la marca pegadiza enmascara los verdaderos problemas éticos que rodean el despliegue de los sistemas de detección facial. Algunas de esas cuestiones incluyen preguntas sobre los sesgos inherentes al código y, en última instancia, cómo se utilizan los datos capturados.

El modelo chino

El Gran Hermano está mirando. Ningún otro país del mundo tiene más vigilancia por video que China. Con 170 millones de cámaras de vídeovigilancia y unos 400 millones de cámaras nuevas instaladas, es un país que ha adoptado e implantado el reconocimiento facial de forma orwelliana.

En un futuro próximo, sus ciudadanos, y aquellos de nosotros que viajamos allí, estaremos expuestos a una vasta e integrada red de sistemas de reconocimiento facial que monitorean todo, desde el uso del transporte público hasta el exceso de velocidad y la cantidad de papel higiénico que uno usa en el baño público.

El elemento más perturbador hasta ahora es la reciente introducción del reconocimiento facial para controlar el comportamiento de los niños en las escuelas públicas chinas.

Como parte de la plena integración de China de su sistema de crédito social igualmente orwelliano -un programa de incentivos que premia el compromiso de cada ciudadano con la moral dictada por el Estado-, este sistema digital totalmente integrado identificará automáticamente a una persona. Puede entonces determinar la capacidad de uno para progresar en la sociedad -y, por extensión, la situación económica y social de la familia inmediata de la persona- mediante el monitoreo del comportamiento no sancionado por el Estado.

En esencia, el reconocimiento facial hace imposible que las personas expuestas puedan darse el lujo de tener un mal día.

Los sistemas de reconocimiento facial que ahora se están implementando en las escuelas chinas están monitoreando todo, desde la asistencia a clase hasta si un niño está soñando despierto o prestando atención. Se trata de un sistema de monitorización integral que determina, en gran medida, el futuro de un niño sin tener en cuenta que algunas cualidades, como el pensamiento abstracto, no pueden detectarse fácilmente o, en el mejor de los casos, considerarse favorablemente, con el reconocimiento facial.

También plantea algunas nociones muy incómodas de la ética o la falta de ética, especialmente hacia los miembros más vulnerables de la sociedad.

Necesidad de una regulación pública

El lanzamiento de RealNetworks de SAFR sigue al apasionado manifiesto del presidente de Microsoft, Brad Smith, sobre la necesidad de regulación pública y responsabilidad corporativa en el desarrollo e implementación de la tecnología de reconocimiento facial.

Smith señaló con razón que las herramientas de reconocimiento facial todavía están algo sesgadas y tienen “mayores tasas de error para las mujeres y las personas de color”. Este problema es doble, con el reconocimiento de que las personas que codifican pueden inconscientemente incrustar sesgos culturales.

Es posible que los conjuntos de datos actualmente disponibles carezcan de la solidez objetiva necesaria para garantizar que los rostros de las personas no se identifiquen erróneamente o, lo que es peor, se predeterminen a través de un sesgo codificado, como está empezando a ocurrir en el sistema escolar chino.

En un esfuerzo por abordar este y muchos otros problemas relacionados, Microsoft estableció un Comité de IA y Ética en Ingeniería e Investigación (AETHER). Este comité también se ha creado para ayudarles a cumplir con el recién aplicado Reglamento General de Protección de Datos (GDPR) de la Unión Europea y su futura adopción, de alguna forma, en América del Norte.

El ardiente atractivo de Smith cuestiona, con razón, el uso y la implementación actual y futura de los sistemas de reconocimiento facial, pero no aborda la forma en que Microsoft o, por extensión, otros líderes de la tecnología de inteligencia artificial pueden eliminar los sesgos dentro de su código base o conjuntos de datos desde el principio.

Minority report

Como muchas tecnologías, Pandora ya ha salido de la caja. Si tienes un teléfono inteligente y utilizas Internet, ya has optado por dejar de lado cualquier noción básica de anonimato personal dentro de la sociedad occidental.

Con GDPR ahora plenamente comprometido en Europa, visitar un sitio web ahora requiere que usted “opte” por la posibilidad de que ese sitio web pueda estar recopilando datos personales. Los sistemas de reconocimiento facial no tienen medios para seguir las reglas de GDPR, por lo que nosotros, como sociedad, estamos automáticamente “optados (opt in)” y, por lo tanto, completamente a merced de cómo nuestras caras están siendo grabadas, procesadas y almacenadas por sistemas de vídeovigilancia gubernamentales, corporativos o incluso de despliegue privado.

Los ensayos de reconocimiento facial realizados en Inglaterra por la Policía Metropolitana de Londres han arrojado sistemáticamente una tasa de fracaso del 98%. Del mismo modo, en el suroeste de Gales, los resultados de las pruebas han sido sólo ligeramente mejores, con menos de un 10% de éxito.

Por el contrario, los científicos de la Universidad de California, Berkeley, han llegado a la conclusión de que la variación facial sustancial es un rasgo evolutivo exclusivo de los seres humanos. ¿Dónde está la desconexión?

Si como Marcel Proust ha sugerido, nuestras vidas y por lo tanto nuestras personalidades son identificables por nuestras caras, ¿por qué los sistemas de reconocimiento facial no pueden fácilmente devolver resultados positivos?

La respuesta se remonta a cómo se escribe la programación de la computadora y los conjuntos de datos utilizados por ese código para devolver una coincidencia positiva. Inevitablemente, el código se escribe para apoyar una noción idealizada de tipo facial.

Como tal, las variaciones periféricas como las deformidades faciales naturales o los rasgos faciales afectados por traumas físicos o mentales representan sólo una pequeña fracción de las infinitas variaciones faciales posibles en el mundo. Los conjuntos de datos asumen que somos doppelgängers homogéneos entre sí, sin abordar las micro-variaciones de las caras de los pueblos.

Si ese es el caso, todos estamos sujetos a la posibilidad de que nuestros rostros, interpretados por el creciente despliegue de sistemas de reconocimiento facial inmaduros, traicionen la realidad de quienes somos.

Compartir esto: